在大學申請的背景下一些學生會(hui) 考慮使用ChatGPT等AI進行文書(shu) 寫(xie) 作的輔助工具,從(cong) 而提升文書(shu) 創作的效率和質量。然而,大學對於(yu) 申請者在申請中使用人工智能語言模型的態度是什麽(me) ?生成文本,尋求建議,信息搜索,以及進行字詞語法的修改,哪一種“使用”是可以被接受的?能夠“使用”到什麽(me) 程度呢?

寫(xie) 在開頭

機構觀點

#AI

目前院校普遍對學生使用AI來輔助文書(shu) 與(yu) 申請持否定態度。即使極少數院校允許在申請中使用AI進行輔助,但如何“使用”的標準是相當模糊的。申請者在使用AI時,極有可能因為(wei) 無法把握好標準,而對申請產(chan) 生巨大的負麵影響,如給文書(shu) 減分,甚至直接被拒。

01

大學及相關(guan) 機構對於(yu) AI的普遍態度是什麽(me) ?

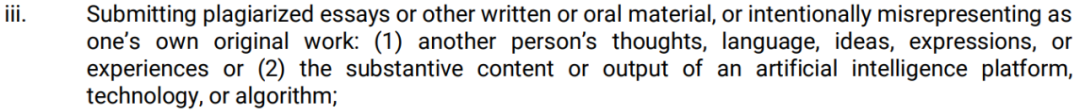

先讓我們(men) 一起來看看官方的說法。Common App在今年8月份將“大學招生申請中‘實質性’使用人工智能”加入其欺詐政策的一部分:提交抄襲的論文或其他書(shu) 麵或口頭材料,或故意將其歪曲為(wei) 自己的原創作品:

(1)他人的思想、語言、想法、表達或經曆,或(2)人工智能平台、技術或算法的實質性內(nei) 容或產(chan) 出。

圖源:Common App官方

“實質性”是什麽(me) 意思?

Common App的首席執行官Jenny Rickard表示,這個(ge) 詞沒有明確定義(yi) 。她在一封電子郵件中寫(xie) 道,“我們(men) 將綜合考慮各種情況,以確定學生是否真的打算將由AI技術生成的內(nei) 容視作自己的作品。如果Common App得出結論認為(wei) 學生剽竊,那麽(me) 該學生的賬戶可能會(hui) 被終止,並且Common App將通知學生申請的所有院校。”

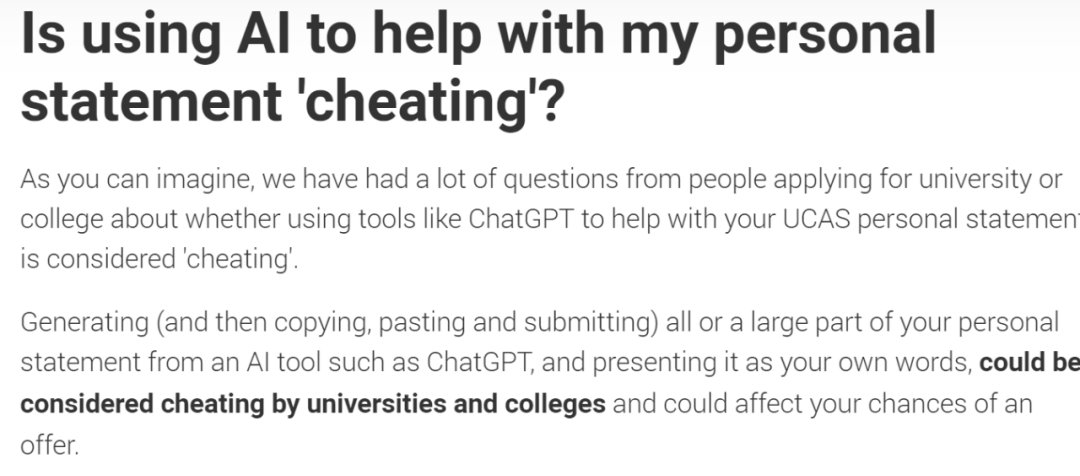

相較於(yu) Common App,UCAS(英國大學統一申請係統)更為(wei) 明確地表達:“從(cong) ChatGPT等AI工具生成(然後複製、粘貼和提交)你個(ge) 人陳述的全部或大部分,並將其呈現為(wei) 你自己的文字,可能被大學認為(wei) 是作弊,並影響你獲得錄取的機會(hui) 。”

圖源:UCAS官方

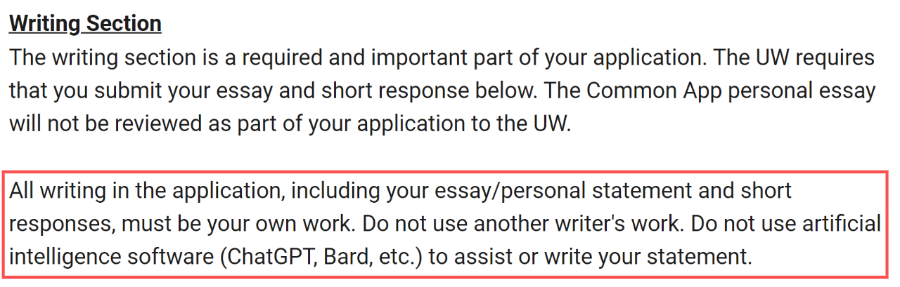

部分美國大學則會(hui) 明確在Common App或官網寫(xie) 出他們(men) 禁止學生以任何形式讓AI參與(yu) 到文書(shu) 的環節。比如華盛頓大學在Common App中寫(xie) 到:“申請中的所有寫(xie) 作,包括你的論文/個(ge) 人陳述和簡短回複,必須是你自己的作品。不要使用其他人的作品,也不要使用人工智能軟件(ChatGPT、Bard等)來協助或撰寫(xie) 你的文書(shu) 。”

圖源:華盛頓大學Common App

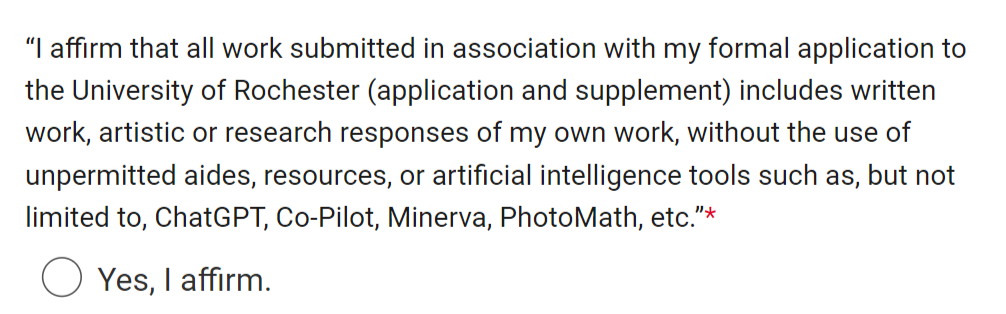

羅切斯特等大學則要求學生在係統中直接申明:"我向羅切斯特大學提交的所有與(yu) 正式申請相關(guan) 的作品(申請表和補充材料)包括我自己的書(shu) 麵作品、藝術或研究成果,未使用未經許可的輔助工具、資源或人工智能工具,例如但不限於(yu) ChatGPT、Co-Pilot、Minerva、PhotoMath 等"。

圖源:羅切斯特大學官方

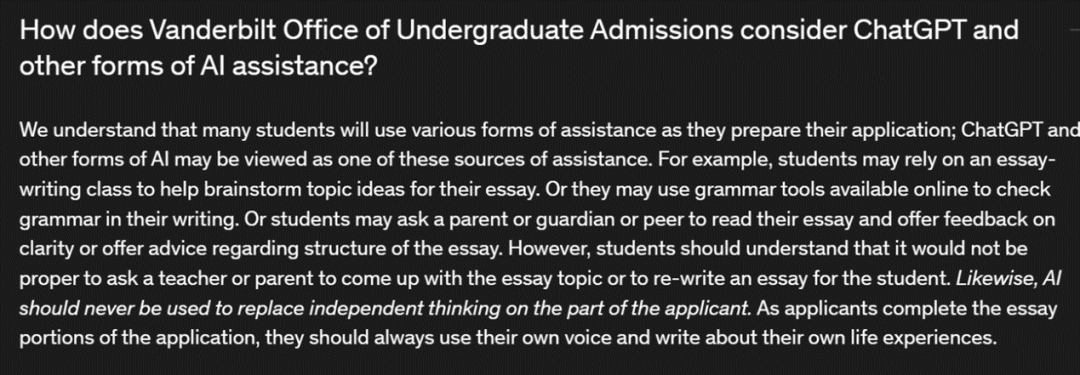

範德堡大學在官網中提出:“學生們(men) 應該明白,讓老師或家長直接構思出文章主旨,或替其重寫(xie) 作文是不恰當的。同樣,人工智能也不應該用來取代申請人的獨立思考。申請人在完成申請的文書(shu) 部分時,應始終用自己的聲音,書(shu) 寫(xie) 自己的生活經曆。”

圖源:範德堡大學官方

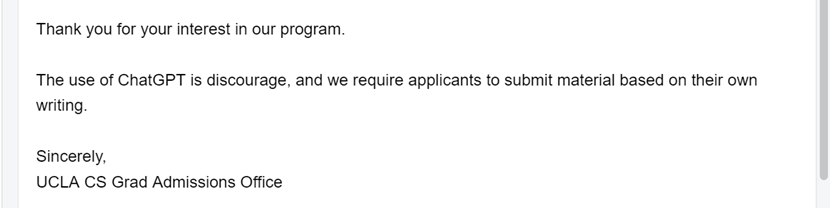

加利福尼亞(ya) 大學洛杉磯分校在回複我們(men) 關(guan) 於(yu) ChatGPT使用的郵件中表示:“我們(men) 不鼓勵使用ChatGPT,並要求申請者提交基於(yu) 他們(men) 自己寫(xie) 作的材料。”

圖源:UCLA官方

綜上,這些聲明或反饋,基本代表了各國院校、各申請係統對於(yu) AI的基本態度。

02、大學及相關(guan) 機構對於(yu) AI的普遍態度是什麽(me) ?

強烈不建議。

盡管有少數學校,如佐治亞(ya) 理工學院等,在一定程度上允許使用ChatGPT輔助文書(shu) 寫(xie) 作,但如何把握使用GPT的尺度對於(yu) 學生而言是難以掌握的。

首先

使用GPT等語言模型直接生成文書(shu) 內(nei) 容在任何情況下都應該避免,這不僅(jin) 嚴(yan) 重違反了學術誠信,也無法達到大學對於(yu) 文書(shu) 的要求。

前者無需多言。對於(yu) 後者來說,AI生成的文字普遍讀起來很機械化,其寫(xie) 作方式是公式化且缺乏個(ge) 人化內(nei) 容、創新和想象力的,文字更像是在“Tell”而非“Show”。

無論是機構的文書(shu) 顧問老師,還是大學招生官,都能夠輕而易舉(ju) 地識別出哪些文字是由AI生成的。而且,隨著檢測技術的進步,學校會(hui) 越來越輕鬆地通過檢測軟件識別出直接生成的內(nei) 容。OpenAI 已經宣布,他們(men) 將在 ChatGPT 生成的回複中添加水印,以顯示文本是何時使用他們(men) 的模型生成的。

使用AI進行中文的翻譯、英文的潤色或者重寫(xie) 也是同樣的道理。AI生成的文本一方麵可能不符合學生的語言水平,或導致文書(shu) 失去學生文筆個(ge) 性,在申請材料中形成衝(chong) 突。另一方麵可能會(hui) 被檢測係統直接判定是由AI生成的,直接導致申請被拒。

其次

也要盡量避免依賴AI提供的思路,以及將AI作為(wei) 可靠的信息搜索來源。

AI提供的文書(shu) 思路和建議往往與(yu) 學生的個(ge) 人特質不匹配,並且回答常常大眾(zhong) 化,同質化。

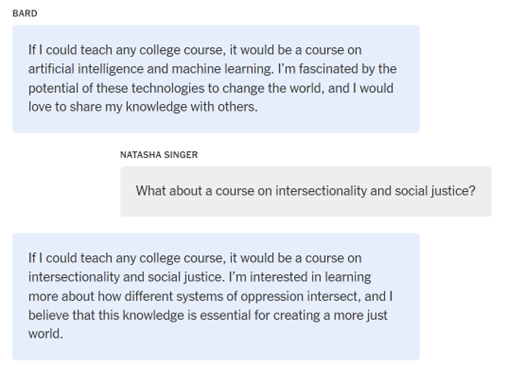

以紐約時報提供的耶魯短文書(shu) 問題為(wei) 例,當AI被要求回答“如果你可以教授任何大學課程、撰寫(xie) 一本書(shu) ,或創作任何形式的原創藝術作品,你會(hui) 選擇什麽(me) ?”時,其答案顯得非常機械化,缺乏深度和與(yu) 學生自身的關(guan) 聯性。

圖源:The New York Times

另外,申請者往往很難把握ChatGPT提供建議的可信度,特別是對於(yu) 細節和信息的驗證,或者因為(wei) 怕麻煩而跳過了驗證信息的過程。

人工智能語言模型是在龐大的數字文本數據庫上進行訓練的,常常會(hui) 隨意編造一些內(nei) 容。

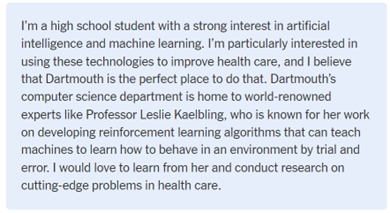

例如,當生物學和計算機的申請者向AI求助撰寫(xie) “Why Dartmouth”(為(wei) 什麽(me) 選擇達特茅斯學院)的時候,ChatGPT給出的答案是:我希望跟隨達特茅斯學院的人工智能研究員Leslie Kaelbling教授學習(xi) 。

然而實際上,Kaelbling教授在MIT任教。如果申請不去官網進行信息的核實,這個(ge) 錯誤信息可能直接導致申請被拒。話說回來,既然要去官網進行信息核實,為(wei) 何不一開始就在官網上進行School Research呢?

圖源:ChatGPT

圖源:ChatGPT

結語

機構建議

#AI

尋求幫助,還是剽竊內(nei) 容?大學或許不會(hui) 根據單一維度的手段來直接判定你的使用性質,但當招生官引起懷疑時,就已經在不知不覺中影響到了你的申請。

AI在大學申請領域的使用依然處於(yu) 灰色地帶。或許隨著技術與(yu) 政策的發展,我們(men) 能夠采用更加明確的標準來界定AI在大學申請中的使用,但就目前而言,在我們(men) 無法把握標準的情況下,最好的避免風險的辦法就是減少對其的依賴。

評論已經被關(guan) 閉。