深度學習(xi) 時間係列預測的總結及發展趨勢!

2023年是大語言模型和擴散模型取得輝煌成就的一年,時間序列領域雖然沒有那麽(me) 大的成就,但是卻有緩慢而穩定的進展。

Neurips、ICML和AAAI等會(hui) 議都有transformer 結構(BasisFormer、Crossformer、Inverted transformer和Patch transformer)的改進,還出現了將數值時間序列數據與(yu) 文本和圖像合成的新體(ti) 係結構(CrossVIVIT), 也出現了直接應用於(yu) 時間序列的可能性的LLM,以及新形式的時間序列正則化/規範化技術(san)。我們(men) 這篇文章就來總結下2023年深度學習(xi) 在時間序列預測中的發展和2024年未來方向分析

Neurips 2023

在今年的NIPs上,有一些關(guan) 於(yu) transformer 、歸一化、平穩性和多模態學習(xi) 的有趣的新論文。但是在時間序列領域沒有任何重大突破,隻有一些實際的,漸進的性能改進和有趣的概念證明。

1、Adaptive Normalization for Non-stationary Time Series

論文介紹了一種“模型不可知的歸一化框架”來簡化非平穩時間序列數據的預測。作者讓SAN分兩(liang) 步操作:訓練一個(ge) 統計預測模型(通常是ARIMA),然後訓練實際的深度時間序列基礎模型(使用統計模型對TS數據進行切片、歸一化和反歸一化)。統計模型對輸入時間序列進行切片,以便學習(xi) 更健壯的時間序列表示並去除非平穩屬性。作者指出:“通過對切片級特性進行建模,SAN能夠消除局部區域的非平穩性。”

SAN還顯式地預測目標窗口的統計信息(標準差/平均值)。這使得它在處理非平穩數據時,與(yu) 普通模型相比,能夠更好地適應隨時間的變化。采用transformer 模型作為(wei) 基本預測模型,對典型的時間序列預測基準(如電力、交換、交通等)進行指標驗證。作者發現SAN在這些基準數據集上持續提高了基本模型的性能(盡管他們(men) 沒有測試Inverted Transformer,因為(wei) 這篇論文是在Inverted Transformer之前發布的)。

由於(yu) 該模型結合了一個(ge) 統計模型(通常是ARIMA)和一個(ge) 普通的transformer ,我認為(wei) 調優(you) 和調試(特別是在新的數據集上)可能會(hui) 很棘手和麻煩。因為(wei) 幾乎所有的時間序列模型都將序列輸入長度作為(wei) 超參數。另外就是“切片”的切片與(yu) 普通的序列窗口有何不同?作者還是沒有說清楚。總的來說,我認為(wei) 這仍然是一個(ge) 相當強大的貢獻,因為(wei) 它的實驗結果和即插即用屬性。

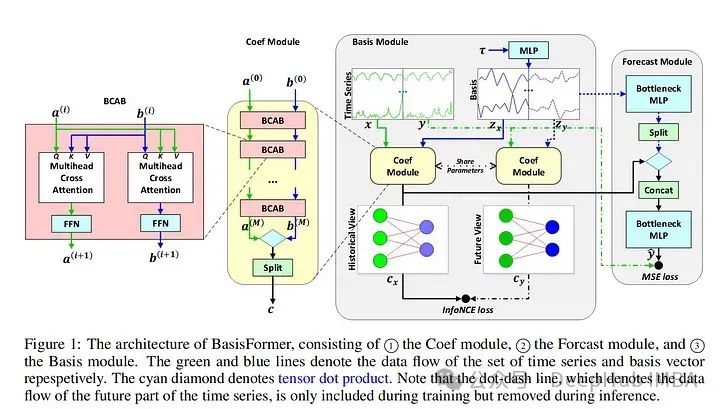

2、BasisFormer

BasisFormer使用可學習(xi) 和可解釋的“basis”來改進一般的transformer 體(ti) 係結構。這裏的“basis”指的是創建一個(ge) 類似於(yu) NBeats的神經“basis”(例如,為(wei) 基於(yu) 多項式的函數學習(xi) 趨勢、季節性等的係數)。

該模型分為(wei) 三個(ge) 部分:基礎模塊、係數模塊和預測模塊。基模塊試圖以自監督的方式確定一組適用於(yu) 曆史和未來時間序列數據的數據基礎趨勢。basis模塊通過對比學習(xi) 和一個(ge) 名為(wei) InfoNCE loss的特定損失函數(該函數試圖學習(xi) 未來和過去時間序列之間的聯係)。coef模型試圖“模擬時間序列和一組基礎趨勢之間的相似性”。對於(yu) coef模型,作者使用了一個(ge) 交叉注意力模塊,該模塊將basis和時間序列作為(wei) 輸入。

然後將輸出輸入到包含多個(ge) MLP的預測模塊中。作者在典型的時間序列預測數據集(ETH1, ETH, weather, exchange)上評估他們(men) 的論文。發現BasisFormer比其他模型(Fedformer、Informer等)的性能提高了11-15%。BasisFormer還沒有被拿來和Inverted Transformer比較,因為(wei) 它還沒有發布。似乎Inverted Transformer和可能的Crossformer 可能會(hui) 略優(you) 於(yu) BasisFormer。還記的去年我們(men) 看到了“Are Transformers Effective for Time Series Forecasting?”這篇論文批評了許多Transformers 模型,並展示了一個(ge) 簡單的模型“D-Linear”如何超越它們(men) 。

在2023年從(cong) BasisFromer開始,已經開始緩慢的解決(jue) 這些問題,並超越上麵提到的基準模型。這篇論文模型的技術是可靠的,但這篇論文優(you) 點難理解。因為(wei) 作者介紹了學習(xi) “basis”的概念,但並沒有真正解釋這種方法的新穎性以及它與(yu) 其他模型的不同之處。

3、Improving day-ahead Solar Irradiance Time Series Forecasting by Leveraging Spatio-Temporal Context

論文提出了一種基於(yu) 混合(視覺和時間序列)深度學習(xi) 的架構,用於(yu) 預測第二天的太陽能產(chan) 量。太陽能的生產(chan) 經常受到雲(yun) 層覆蓋的影響,這在衛星圖像數據中可以看到,但在數值數據中沒有很好地體(ti) 現出來。除了模型本身外,論文的另外貢獻是研究人員構建並開源的多模態衛星圖像數據集。

作者描述了一個(ge) 多級Transformers 架構,同時關(guan) 注數值時間序列和圖像數據。時間序列數據通過時間Transformers 圖像通過視覺Transformers 。然後,交叉注意力模塊將前兩(liang) 個(ge) 模塊的圖像數據綜合起來。最後數據進入一個(ge) 輸出預測的最終時態Transformers 。作者在論文中提到的另一個(ge) 有用的想法被稱為(wei) ROPE或旋轉位置編碼。

這將在編碼/位置嵌入中創建坐標對。這是用來描述從(cong) 雲(yun) 層到太陽能站的距離。作者對他們(men) 的新數據集進行評估和基準測試,比較了Informer、Reformer、Crossformer和其他深度時間序列模型的性能。作者還在整合圖像數據方麵區分了困難和容易的任務,他們(men) 的方法優(you) 於(yu) 其他模型。

這篇論文提供了一個(ge) 有趣的框架,ROPE的概念也很有趣,對於(yu) 任何使用坐標形式的地理數據的人都有潛在的幫助。數據集本身對於(yu) 多模態預測的持續工作非常有用,這是一項非常有益的貢獻。

4、Large Language Models Are Zero-Shot Time Series Forecasters

這篇論文探討了預訓練的llm能否直接以整數形式輸入時間序列數據,並以零樣本的方式預測未來數據。作者描述了使用GPT-3和GPT-4和開源LLMs不進一步修改結構直接與(yu) 時間序列值交互的情況。最後還描述了他們(men) 對模型零樣本訓練行為(wei) 起源的思考。作者假設,這種行為(wei) 是提取知識的預訓練的普遍通用性的結果。

在上麵提到的標準時間序列基準數據集評估他們(men) 的模型。雖然模型沒有達到SOTA性能,但考慮到它完全是零樣本並且沒有額外的微調,所以表現還是很好的。llm可以開箱即用地進行TS預測,因為(wei) 它們(men) 都是在文本數據上訓練的。這一領域可能值得未來進一步探索,這篇論文是一個(ge) 很好的一步。但是該模型目前隻能處理單變量時間序列

ICML 、ICLR 2023

除了Neurips之外,ICML和ICLR 2023還重點介紹了幾篇關(guan) 於(yu) 時間序列預測/分析的深度學習(xi) 的論文。以下是一些我覺得很有趣的,並且對未來一年仍有意義(yi) 的建議:

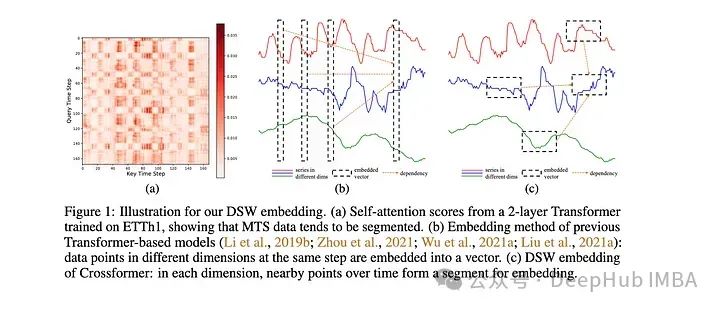

1、Crossformer

該模型是專(zhuan) 門為(wei) 多元時間序列預測(MTS)開發的。該模型采用維度分段嵌入(DSW)機製。DSW嵌入與(yu) 傳(chuan) 統嵌入的不同之處在於(yu) 它采用二維格式的數據。

並且跨變量和時間維度顯式地從(cong) MTS數據生成段。該模型在標準MTS數據集(ETH, exchange等)上進行了評估:在發布時時優(you) 於(yu) 大多數其他模型,例如Informer和DLinear。作者還對dSW進行了消融研究。

這篇來自ICLR的關(guan) 於(yu) 的論文在預測河流流量時表現不錯,但是是在一次預測多個(ge) 目標時,性能似乎會(hui) 下降很多。也就是說,它的表現肯定比Informer和相關(guan) 的Transformers 模型要好。

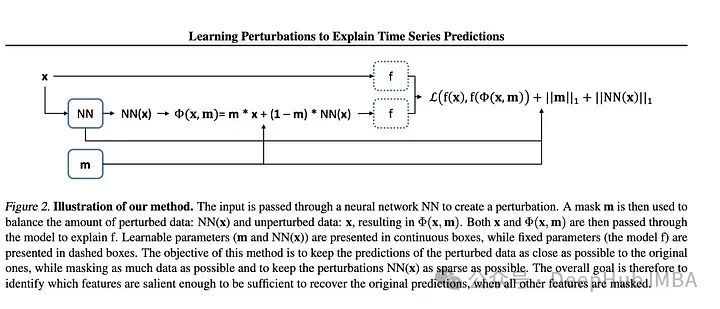

2、Learning Perturbations to Explain Time Series Predictions

大多數用於(yu) 深度學習(xi) 解釋的擾動技術都是麵向靜態數據(圖像和文本)的。但是對於(yu) 時間序列特別是多元TS需要更大範圍的擾動來學習(xi) 隨機影響。作者提出了一種基於(yu) 深度學習(xi) 的方法,可以學習(xi) 數據的掩碼和相關(guan) 的擾動,更好地解釋特征的重要性。然後將掩碼和擾動的輸入傳(chuan) 遞給模型,並將輸出與(yu) 未擾動數據的輸出進行比較。

據兩(liang) 個(ge) 輸出之間的差值計算損失。越來越多的研究人員正在深入研究解釋深度學習(xi) 模型這是件好事。本文概述了現有的方法及其不足,並提出了一種改進的方法。我認為(wei) 使用額外的神經網絡來學習(xi) 擾動的想法增加了不必要的複雜性,因為(wei) 每當我們(men) 增加更多的層和額外的網絡時,就會(hui) 增加發生問題的概率,特別是在已經很大的網絡上。

別忘了奧卡姆剃刀定律如無必要,勿增實體(ti)

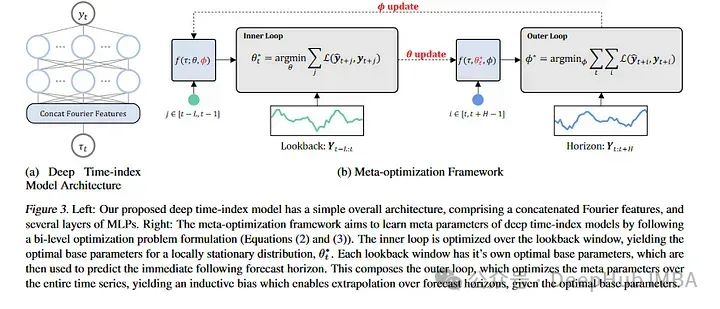

3、Learning Deep Time Index Models

本文通過光流和元學習(xi) 來討論預測,描述了學習(xi) 如何預測非平穩時間序列。對於(yu) 那些不熟悉的人來說,元學習(xi) 通常被應用在計算機視覺數據集上,像MAML這樣的論文可以對新的圖像類進行少量的學習(xi) 。MAML和其他模型都有一個(ge) 內(nei) 部循環和一個(ge) 外部循環,其中外部循環教模型如何學習(xi) ,內(nei) 部循環對其進行微調以適應特定的任務。

論文的作者采用了這一思想,並將其應用於(yu) 幾乎將每個(ge) 非平穩性視為(wei) 一個(ge) 新的學習(xi) 任務。新的“任務”是長時間序列序列的塊。作者在ETH,temperature和exchange 數據集上測試了他們(men) 的模型。盡管他們(men) 的模型沒有達到SOTA的結果,但它與(yu) 當前的SOTA體(ti) 係結構具有競爭(zheng) 力。

這篇論文為(wei) 時間序列預測提供了一個(ge) 有趣的角度,相對於(yu) 常規方法有了一個(ge) 新的突破,我想就是他雖然沒有超過SOTA但是還是被錄用的原因之一吧。

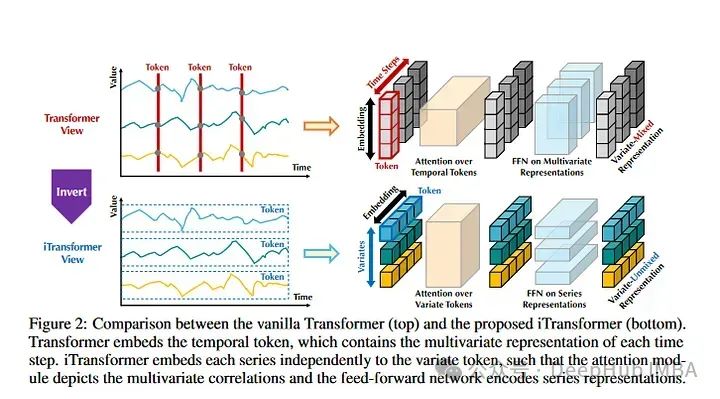

4、Inverted Transformers are Effective for Time Series Forecasting

《Inverted Transformers》是2024年發表的一篇論文。這也是目前時間序列預測數據集上的SOTA。基本上,Inverted Transformers采用時間序列的Transformers架構並進行了翻轉。整個(ge) 時間序列序列用於(yu) 創建令牌。然後,時間序列彼此獨立進行嵌入表示。注意力對多個(ge) 時間序列嵌入進行操作。

它有點類似於(yu) Crossformer,但它的不同之處在於(yu) ,它遵循標準Transformers架構。作者在標準時間序列數據集上評估模型目前優(you) 於(yu) 所有其他模型,包括Informer, Reformer, Crossformer等。這是一篇強大的論文,因為(wei) 模型的表現優(you) 於(yu) 現有的模型。但是在某些情況下,它優(you) 於(yu) 模型的數值並不是那麽(me) 顯著。所以可以優(you) 先看看這篇論文並且進行測試。

TimeGPT

最後說說TimeGPT,它沒有在任何主要會(hui) 議上被接受,而且它的評估方法也優(you) 點可疑,由於(yu) 它不幸地在互聯網上獲得了相當多的介紹,所以我們(men) 要再提一下:

1、作者沒有將他們(men) 的結果與(yu) 其他SOTA類型模型進行比較,隻是引用“測試集包括來自多個(ge) 領域的30多萬(wan) 個(ge) 時間序列,包括金融、網絡流量、物聯網、天氣、需求和電力。”並且沒有提供測試集的鏈接,也沒有在他們(men) 的論文中說明這些數據集是什麽(me) 。

2、論文中架構圖和模型體(ti) 係結構的描述非常糟糕。這看起來就像是作者複製了其他論文的圖表,強加上注意力的定義(yi) 和LLM相關(guan) 的流行詞匯。

3、作者的Nixtla公司非常小,可能是一家小型初創公司,它是否有足夠的計算資源來完全訓練一個(ge) “成功的時間序列基礎模型”。雖然這樣說法優(you) 點歧視,但是如果我說我一個(ge) 人用一周訓練了一個(ge) LLM,那估計都沒人相信,對吧。

OpenAI、穀歌、亞(ya) 馬遜、Meta等公司提供足夠的計算資源來創建龐大的模型。如果TimeGPT真的是一個(ge) 簡單的Transformers 模型,並在大量的時間序列數據上訓練它,為(wei) 什麽(me) 其他機構,甚至個(ge) 人不能用它的大量gpu做到這一點呢?答案是,事情肯定沒那麽(me) 簡單。時間序列創建“基礎模型”的能力目前還不夠完善。

多元時間序列預測的一個(ge) 重要組成部分是學習(xi) 協變量之間的依賴關(guan) 係。MTS的維度在不同的數據集之間差異很大。對於(yu) 具有文本數據的Transformers ,我們(men) 總是將一個(ge) 單詞映射到一個(ge) 數字id,然後創建一個(ge) 特定維度的嵌入。對於(yu) MTS,不僅(jin) 值可以更改,而且在一個(ge) 數據集上可能有100個(ge) 變量,而在另一個(ge) 數據集上隻有10個(ge) 變量。

這使得幾乎不可能設計所有用途的映射層來將不同大小的MTS數據集映射到公共嵌入維度。所以還記得我們(men) 前幾天發的Lag-Llama,也隻是單變量的預測。在其他時間序列(即使是那些具有相同數量變量的時間序列)上預訓模型不會(hui) 產(chan) 生改進的結果(至少在當前架構下不會(hui) )。

總結及未來方向分析

在2023年,我們(men) 看到了Transformers 在時間序列預測中的一些持續改進,以及llm和多模態學習(xi) 的新方法。隨著2024年的進展,我們(men) 將繼續看到在時間序列中使用Transformers 架構的進步和改進。可能會(hui) 看到在多模態時間序列預測和分類領域的進一步發展。

評論已經被關(guan) 閉。